Update Google : comment s’y préparer ?

Redoutés par les non-experts et même par une partie des professionnels du SEO, les updates annoncés par Google, avec une communication bien choisie, sont souvent relayés avec un ton apocalyptique. Qu’en est-il réellement et comment agir pour éviter les mauvaises surprises et au contraire en tirer potentiellement partie ?

L’algorithme Google : quand tout change…

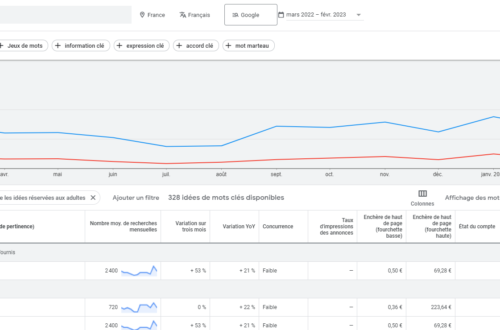

C’est un « marronnier » du SEO : « l’algorithme de Google change sans arrêt » ! A cette quinzaine d’updates importants en 2021 qu’on retrouve dans cette infographie réalisée par OnCrawl, il faut ajouter près de 400 ajustements réalisés chaque année (plus de 1 par jour) et bien sûr les nouvelles features dans les résultats de recherche.

Les mises à jour les plus craintes par les communautés SEO et les marketeurs sont bien sûr les fameux « Core Updates », ces mises à jour plus importantes de l’algorithme, qui peuvent recevoir un nom – par exemple, « Spam Update » en 2021, ou « Helpful Content » en 2022.

Toutes ces mises à jour sont souvent amplement relayées sur les sites de webmarketing ou dédiés au SEO, et l’idée de cet article n’est pas de les énumérer de manière exhaustive mais de prendre un peu de hauteur sur le sujet.

… mais rien ne change sur le fond

Je pratique le SEO depuis une dizaine d’années, peu de temps après le filtre Panda (qui en son genre est un type d’update précis de Google). Il est évident que dans les pratiques du référencement, il y a eu un avant et un après.

- Dans les contenus, j’ai pu mettre à jour d’anciens articles et mis en places de nouvelles normes éditoriales davantage qualitatives.

- Au niveau de l’acquisition de liens, j’ai dû faire preuve de vigilance, et les plus experts que moi m’ont à l’époque amplement expliqué comment ils avaient tendance à procéder « avant » et comment il fallait procéder « désormais » – être plus prudent et qualitatif.

- Techniquement, comme je l’ai entendu dire par Olivier Andrieu lui-même, un site bien réalisé il y a 10 ans sera toujours techniquement valable en SEO aujourd’hui.

Une idée revient sur chacun de ces 3 « piliers » du SEO : aller dans le sens du plus qualitatif. Mais qu’est-ce que la qualité pour Google ?

- Des contenus uniques, intéressants et à jour pour l’utilisateur – pas de la duplication, du « remplissage », ou pire, des pages sans contenus éditoriaux à proprement parler (exemple plus bas dans l’article).

- Des liens reçus naturellement parce que les contenus sont justement de qualité. Ils viennent un peu telle la pluie arrosant les bonnes semences dans un sol durement préparé, faisant germer dans les résultats de recherche les plus beaux plants. D’ailleurs, on ne parle pas de netlinking (qui sous-entend, peut-être, une prise en main du sujet, et donc une dose d’engrais d’artificiel…) mais de « popularité » ou d' »autorité ». Un peu telle la popularité d’un livre qui, parce qu’il est bon, fait parler de lui dans les journaux et revues… (mais la comparaison a ses limites, avec les mauvais livres en devanture et les bons réservés à ceux qui savent…)

- Evidemment le respect des best-practices techniques qui facilitent le crawl, le passage du robot de Google, sur lesdites pages de qualité, et lui donnent des indications pour afficher les meilleurs résultats (canonicals, hreflangs, méta descriptions, …). Elles sont bien-sûr agréables pour les utilisateurs (temps de chargement, accessibilité, pas de publicités de manière abusive, …)

Les updates Google ne prennent jamais une autre direction.

Des craintes bien fondées quand on soigne trop ou trop peu son SEO

Cette qualité va parfois à l’encontre des intérêts ou des pratiques des référenceurs ou webmasters, au moins en apparence.

- Les contenus uniques et de qualité ne riment pas avec pas chers (externalisés « offshore ») voire quasiment gratuits (GPT3 et autres outils basés sur l’IA) ; d’autre part, de nombreuses pages n’ont pas de contenu parce que cela ne parait pas naturel d’en avoir pour les non-experts, essentiellement les catalogues en e-commerce.

- Je prenais ci-dessus une métaphore agricole, qui a évidemment des limites, au sujet des liens, en pensant aux sécheresses : les liens, qui restent toujours au cœur de l’algorithme de Google, ne tombent pas comme la pluie, alors qu’ils peuvent être absolument nécessaires ! Pour en savoir plus, je vous invite à lire mon article sur le poids des différents facteurs SEO. Grande est la tentation d’acquérir les liens nécessaires à l’aide d’un budget et de plateformes dédiées…

- Pour la partie technique, si personne n’a la volonté de mal faire, la bande passante n’est pas infinie et souvent dédiée à d’autres priorités, ce qui peut mener à une forme de procrastination sur le SEO (j’y ai dédié cet article). Et à l’inverse du netlinking et du contenu (« keyword stuffing » par exemple), on n’en fait jamais trop !

Les tremblements du « black hat »

En SEO, on parle de Black Hat pour désigner les techniques cherchant à tromper ou à se jouer des guidelines de Google pour remonter « artificiellement » dans ses résultats. Il existe différents degrés, allant d’un peu de malice à la tricherie pure et simple voire au piratage (des concurrents par exemple).

L’une des pratiques les plus répandues en SEO est l’acquisition artificielle de liens, car leur poids est fort notamment pour atteindre les meilleures positions. Il est possible avec de l’expérience de le faire « proprement », cependant il reste toujours un risque, celui de se brûler après avoir joué avec le feu. Il est clair que si l’on doute du bien fondé de ce que l’on a mis en place pour améliorer son référencement, si l’on sait que l’on a peut-être fait du « sale », que l’on est peut-être allé un peu loin, l’annonce d’un update met dans la tourmente car celui-ci peut tout remettre en question !

Il y aura certainement plus à attendre d’un filtre algorithmique visant à pénaliser les mauvaises manières de faire du SEO selon Google. Si l’on reprend l’infographie ci-dessus, le « Google Title Update » sera beaucoup plus inoffensif que le « Spam Update », ou qu’un « Core Update » annoncé sans que sa teneur ne soit très claire.

Tout perdre par omission d’une best-practice

Par ignorance des basiques du SEO pour Google, ou de manière délibérée en opposant au SEO un « less is more », un update de l’algorithme peut aller jusqu’à vous faire perdre tout votre trafic SEO. Je n’ai pas de nombreux cas en tête mais j’en ai rencontré un qui me semble très clair : celui d’un site qui n’a connu absolument aucune évolution durant des mois, et qui très rapidement après l’update « Google Helpful Content » – valorisant comme son nom l’indique la qualité des contenus – a vu chuter drastiquement son trafic.

Mais il est facile de comprendre pourquoi en parcourant le site. Les pages au contenu le plus « riche », soit les quelques pages sur la société et son histoire, se contentent d’à peine 100 mots. Les pages de catalogue ou PLP (Product List Pages) n’ont absolument aucun contenu au sens éditorial du terme (= textuel). Les pages des produits sont pour certaines beaucoup mieux loties, mais la duplication interne est quasiment totale, seule la couleur du produit change d’un descriptif produit à l’autre. Les bonnes pratiques qui auraient dû être mises en place dès le début auraient été a minima :

- Un texte en début et/ou en fin de page de liste de produits pour expliquer ce qui est vendu, avec quelle différence, quelle qualité, quelle utilité…

- Ne pas se contenter de répliquer en changeant la couleur les descriptifs de produits, mais créer une description unique par produit

Autrement dit, plus généralement, ce qui aurait dû être fait ne dépend pas de telle ou telle mise à jour de Google, mais de la mise en pratique du SEO pour s’assurer d’avoir ce trafic de manière pérenne. A partir du moment où le site est correctement optimisé, il n’y a plus à craindre les foudres de Google !

Et votre site, êtes-vous sûr qu’il passera sereinement le prochain update ?